ジョイコンが不調になった

スイッチ発売直後ぐらいから、ジョイコンのスティックが静止状態にできないというJoy-Conドリフトが問題視されていて、アメリカでは集団訴訟が起きてるようでした。

運よく発売当日にスイッチを入手できたものの、まともに遊んだのはゼルダとスニッパーズぐらいで、特にスティック不調を感じることもなく数年たちました。

どうぶつの森とマイクラでドリフト発症した

スイッチ版のどうぶつの森を遊んだあたりで、ドリフトがすこし発生し始めましたが、ごまかしごまかしで使っていました。

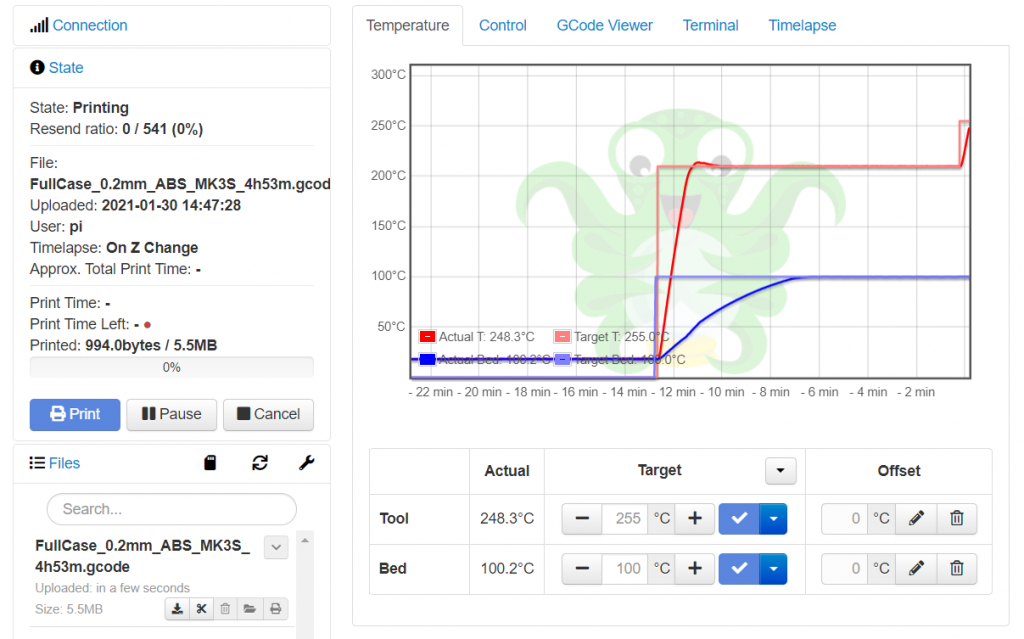

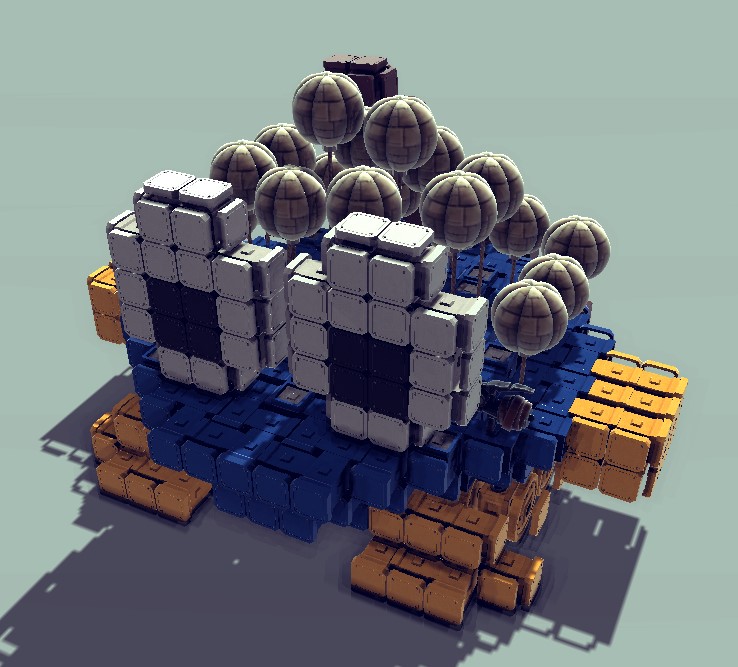

去年の夏ごろにNintendo Switch Online加入者向けに、マイクラダンジョンズが期間限定無料で遊べるキャンペーンが実施されたのをきっかけに、ダンジョンズではないほうのマイクラを遊び始めたところ、スティックが本格的に不調になりました。

スティックを交換することにした

エンチャントするときにドリフトで別の項目を選んでしまったりするようになってきたので、面倒だけどあきらめてスティックを交換することにしました。

Joy-Conドリフトの話題をみかけたころ(数年前)に、将来の不調に備えてAliexpressでスティックをいくつか購入していたので、それに交換しようと思ったのですが、すこし調べてみると最近のスティック部品はすこしドリフト発症を抑えるような改良がされているらしく、それほど高い部品でもないので、新しいスティックを買うことにしました。

買ったのはこちら

メインの商品画像に文字が入ってるあたり、あまりきちんとした商品ではなさそうな予感ですが、いちおう、商品画像通り、裏面が#型中央に膨らみのある形の品物が届きました。

ドライバーはこちら

任天堂の製品の外装はY字ネジが使われているので、普通のプラスドライバーでは開けられない。

2mmぐらいのY字ドライバーがちょうどよいというので、ホームセンターでY#2という表記のドライバーを買ってみたら、サイズが全く合わなかった(ドライバーが大きすぎた)ので、アマゾンでアネックスのドライバーを買った。

交換は簡単だった

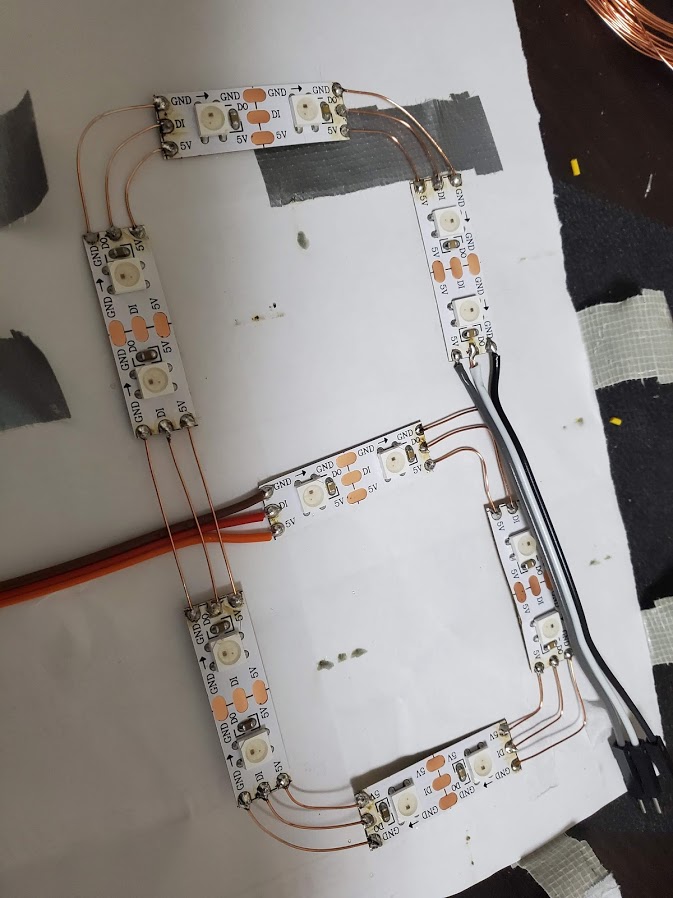

左コントローラーに比べると右コントローラーのほうがIRセンサーがついている分、少し複雑だけど、左コントローラーはスティックのねじ部分に別の部品のフレキシブルケーブルが干渉してるのでいったん抜かないといけないのに対して、右コントローラーはそういったことがないので、右のほうが交換がすこし簡単だった。(フレキの抜き差しやりたくない)

最後に

ジョイコンが不調になってから、1年近く交換するのをためらってたけど、やってみたら予想以上に簡単だった。交換後は今のところ快調に使えている。