Nintendo Labo VR KIT でわいわい楽しむ 1Day ハッカソンに行ってきた。

心構え

「VR KITのラボ機能を使ってオリジナルVRコンテンツを作る集まり」なんだけど、CONNPASSのイベント説明ページに”段ボール等の持ち込みは大歓迎です”とあったので、段ボール工作をするつもりで参加申し込みした。

もくもく作成

切断装備がアクリルカッターとアートナイフだけだったので段ボール相手としてはかなり苦しかった。まともなデカいカッターがあればもうちょっと楽に切れたはず。

あと、どうしても段ボールくずが出てしまうので、コロコロ代わりにダクトテープでこまめに集めてたつもりだけど、ちょっとは回収しきれてないのが残ってるかも・・・申し訳なし。。。

つくったものは

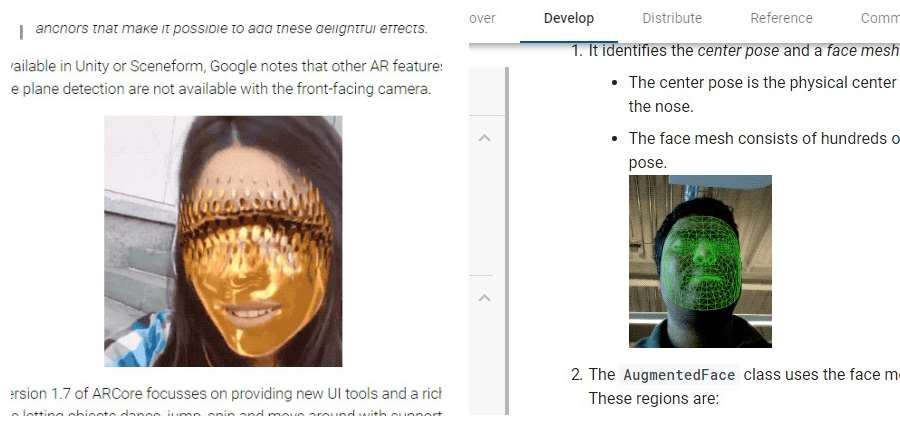

段ボール製のVRホルダーをつくった。これは去年のMakerFaireTokyoに出展したハッピーフォンホルダーと、そのあとに作ったハッピーフェイスマスクに続くハッピーシリーズ第三弾!ハッピーVRホルダー。

現地で完成品だけをキレイに撮影してなかったので、帰ってから取り直した写真が↓コレ。

手の部分は自分の手を段ボール上でなぞってカッターで切り抜いたので実物サイズ。

あと、見切れてて映ってないけど背面端っこのところにカウンターウェイトとして水入りペットボトルを差し込むようになってる。

最後に

twitterにいくつか写真や動画があげてもらってるけど、皆さん興味を持ってくれて順々に試してもらえたので大満足。ほかの参加者の方々が作られた、まっとうな?VRコンテンツはどれもよくできていて素敵だった。

今回は自分も含めて参加者の皆さん全体的にラボ慣れしてない人ばかりで、みんなで手探りしながらノウハウを物理でつぶやいて共有していく感じが楽しかった。

前々からVRホルダーの試作をしようとおもってたので、今回のハッカソンがちょうどよい機会になって無事試作完成できてよかった。もし次回があって参加できそうだったら今度はちゃんとしたコンテンツ作りもやってみたい。良い機会をつくってくださった@ikkouさんに感謝。