VR空間を自由につくれるようになりたい

GearVRとかDayDreamとかWindowsMRとかOculusGOとか、デバイスはそろってきたのでコンテンツを作れるようになりたい。

とりあえずトライしたいのは次の2つ。

モデリングしたものをVR空間でじっくり見てみたい

3Dプリント前にVR空間で手元でじっくり見てみたい。

VR空間でグラフを描画したい

VR空間内でログを立体表示してデバッグしてみたい。

ということで、まずは

Unityの勉強。

いろいろチュートリアルとか本とかあって目移りしてしまうので実現したい機能を決める。

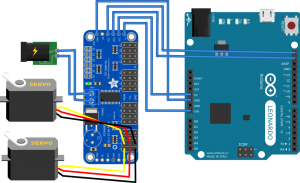

- OculusGO向けにビルドする。

- BlenderでモデリングしたものをUnity空間に配置する。

- 空間内を移動できるようにする。(WindowsMR風)

- タッチパッド左右押しで視点回転

- トリガ押しでテレポート

- タッチパッドクリックでものをつかむ。

- クリックで保持

- パッド前後スワイプで距離変更(VirtualVirtualReality風)

OculusGO向けのビルドは適当にやったらできたので次はオブジェクトをUnitiy内におくのを試してみる。

とりあえずfbxで保存してみたら置けたけど、テクスチャがなくなってしまった。画像ファイルをfbxと同時にD&Dというのも試してみたけどなんかうまくいかず。

BlenderのほうでDecimateというので頂点数を少なくしたのが影響してるような気もする。もともとBlenderのテクスチャがいまひとつよくわかってない。もっとシンプルな箱にテクスチャを張り付けたようなやつで試してみるか。

中途半端だけどとりあえずここまでで記事公開。